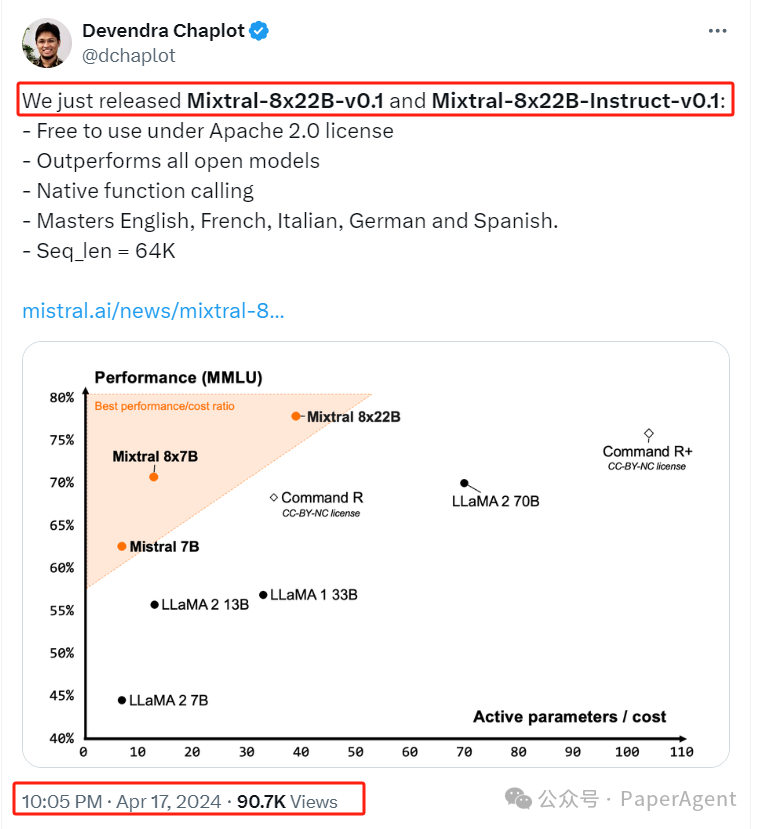

Mistral发布并开源了Mixtral-8x22B-v0.1和Mixtral-8x22B-Instruct-v0.1,Mixtral 8x22B是Mistral最新的开放模型。它为人工智能社区在性能和效率方面树立了新的标准。这是一个稀疏的专家混合(SMoE)模型,在使用的1410亿参数中,只有390亿是活跃的,为其大小提供了无与伦比的成本效率。

- 它的64K令牌上下文窗口允许从大型文档中精确地回忆信息。

在Apache 2.0许可下免费使用

性能超越所有开放模型

我们构建的模型为各自的规模提供了无与伦比的成本效率,提供了社区提供模型中最好的性能-成本比。Mixtral 8x22B是我们开放模型家族的自然延续。它的稀疏激活模式使其比任何密集的70B模型更快,同时比任何其他开放权重模型(在宽松或限制性许可证下分发)更有能力。基础模型的可用性使其成为微调用例的极好基础。 衡量性能(MMLU)与推理预算权衡(活跃参数数量)的指标。Mistral 7B、Mixtral 8x7B和Mixtral 8x22B都属于与其它开放模型相比高度高效的模型家族。在广泛常识、推理和知识基准测试中,顶级领先的LLM开放模型的性能:MMLU(衡量大规模多任务语言理解)、HellaSwag(10-shot)、Wino Grande(5-shot)、Arc Challenge(5-shot)、Arc Challenge(25-shot)、TriviaQA(5-shot)和NaturalQS(5-shot)。

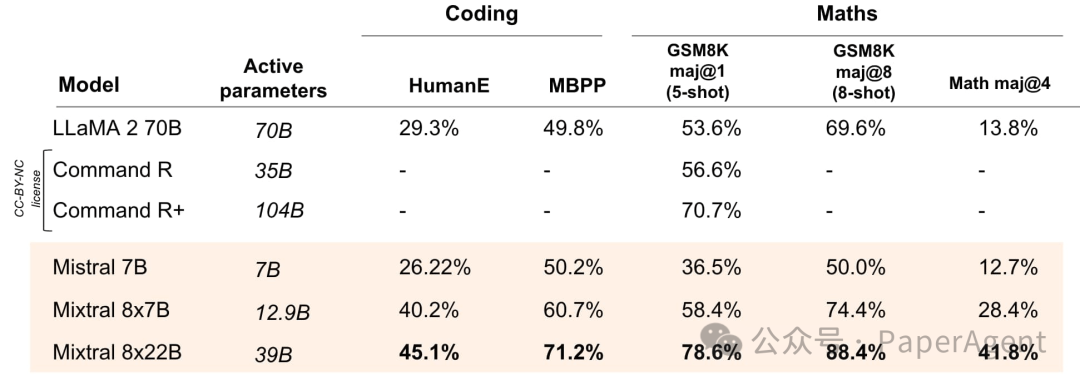

多语言能力 Mixtral 8x22B具有原生的多语言能力。在法语、德语、西班牙语和意大利语的HellaSwag、Arc Challenge和MMLU基准测试中,它的表现大大超过了LLaMA 2 70B。 Mistral开源模型与LLaMA 2 70B在法语、德语、西班牙语和意大利语的HellaSwag、Arc Challenge和MMLU的比较。与其他开放模型相比,Mixtral 8x22B在编码和数学任务中表现最佳。 在领先的开放模型的流行编码和数学基准测试中的表现:HumanEval pass@1、MBPP pass@1、GSM8K maj@1(5-shot)、GSM8K maj@8(8-shot)和Math maj@4。

多语言能力 Mixtral 8x22B具有原生的多语言能力。在法语、德语、西班牙语和意大利语的HellaSwag、Arc Challenge和MMLU基准测试中,它的表现大大超过了LLaMA 2 70B。 Mistral开源模型与LLaMA 2 70B在法语、德语、西班牙语和意大利语的HellaSwag、Arc Challenge和MMLU的比较。与其他开放模型相比,Mixtral 8x22B在编码和数学任务中表现最佳。 在领先的开放模型的流行编码和数学基准测试中的表现:HumanEval pass@1、MBPP pass@1、GSM8K maj@1(5-shot)、GSM8K maj@8(8-shot)和Math maj@4。